Daten, ROI, Integration: Der echte Chatbot-Fahrplan für CTOs und CIOs

KI-Chatbots sind kein Voodoo, sondern Engineering. Viele Projekte scheitern, weil sie als UI-Plugin statt als operatives System betrachtet werden. Für CTOs entscheiden Data Readiness, messbarer ROI und tiefe Integration über den Erfolg. Wir zeigen praxisnah am Beispiel eines autonomen Reiseassistenten, wie der Sprung vom bloßen Antworten zum echten Handeln gelingt und welche Architektur den Live-Betrieb wirklich übersteht.

Führungskräfte im Unternehmensbereich fordern "einen Chatbot", weil es sich wie ein schneller Erfolg anhört: eine Benutzeroberfläche, die Fragen beantwortet, die Support-Last reduziert und Mitarbeiter produktiver macht. Was oft unterschätzt wird, ist das Engineering hinter einem Chatbot, der sicher, zuverlässig und messbar nützlich ist. Im Live-Betrieb ist ein Chatbot keine UI-Funktion. Er ist ein System mit operativen Verantwortlichkeiten.

Der schnellste Weg, Zeit und Budget zu verbrennen, besteht darin, einen KI-Chatbot wie ein Plugin zu behandeln: ein Modell verbinden, ein paar Dokumente hochladen und davon ausgehen, dass der Nutzen folgen wird. Das wird er normalerweise nicht. Die Initiativen, die erfolgreich sind, behandeln drei Voraussetzungen als nicht verhandelbar: Data Readiness, messbarer ROI und Integration, die echte Aktionen ermöglicht.

Jeder möchte einen Chatbot, wenige wollen das Engineering

Es gibt gute Gründe für den "Chatbot-Boom". Support-Teams ertrinken in sich wiederholenden Anfragen. Die interne IT wird zur menschlichen Suchmaschine. Operations-Teams verlassen sich auf Wissen, das über Tools und Stammeswissen verstreut ist. Eine Chat-Oberfläche sieht aus wie der kürzeste Weg zur Selbstbedienung.

Aus Sicht eines CTO muss Erfolg operativ definiert werden. "Der Bot beantwortet Fragen" ist kein Erfolg. Erfolg sind messbare Auswirkungen:

- weniger Tickets, die menschliche Agenten erreichen (Deflection),

- schnellere Bearbeitungszeit für die verbleibenden Tickets,

- weniger Weiterleitungen und Eskalationen,

- konsistente Anleitung im Einklang mit den Richtlinien,

- klare Audit-Trails und kontrollierter Zugriff.

Wenn Sie nicht definieren können, wie der Bot einen messbaren Prozess verändern wird, bauen Sie kein Produkt – Sie bauen eine Demo.

Was funktioniert vs. was scheint zu funktionieren

Die Demo-Falle

Eine Chatbot-Demo kann unter Happy-Path-Bedingungen beeindruckend aussehen: saubere Fragen, kuratierte Dokumente und keine echten Sicherheitsgrenzen. Die Illusion bricht in dem Moment zusammen, in dem sie auf die Produktionsrealität trifft – mehrdeutige Anfragen, fehlender Kontext, widersprüchliche Dokumente und Benutzer, die Edge Cases testen.

Das Kernrisiko besteht nicht darin, dass der Bot manchmal "Ich weiß es nicht" sagt. Das Kernrisiko besteht darin, dass er selbstbewusst antwortet, während er falsch liegt. In Unternehmensumgebungen sind selbstbewusste falsche Antworten schlimmer als keine Antwort, weil sie nachgelagerte Arbeit erzeugen: Eskalationen, Nacharbeiten, Richtlinienverstöße und Vertrauensverlust.

Ein großer Teil der Schadensbegrenzung ist hier Interface-Psychologie und UX, nicht nur Modellqualität. Wenn die UI jede Antwort mit derselben "Vertrauenshaltung" präsentiert, werden Benutzer dem System übermäßig vertrauen.

Praktische Muster, die Schaden reduzieren:

- Vertrauensindikatoren, die auf Evidenz basieren: Der Bot sollte explizit kommunizieren, ob er starke Unterstützung in internen Dokumenten gefunden hat.

- Quellen-erste Interaktion: Zeigen Sie den Richtlinien-/Dokumentenabschnitt, der die Antwort unterstützt.

- Sichere Ablehnung durch Design: Verwenden Sie vordefinierte "sichere Phrasen", wenn die Beweise unzureichend sind.

- "Ich kann dies in der aktuellen Wissensdatenbank nicht bestätigen. Ich kann ein Ticket für den zuständigen Verantwortlichen erstellen oder Sie an einen menschlichen Agenten weiterleiten."

- "Ich habe nicht genügend verifizierte Informationen, um zuverlässig zu antworten. Hier ist, was ich bestätigen kann, und was unklar bleibt."

- Hochrisiko-Gating: Für HR-, Rechts-, Finanz- oder Sicherheitsthemen verlangen Sie explizite Zitate; andernfalls ablehnen oder eskalieren.

Die Produktionsanforderungen

Produktions-Chatbots müssen unter Einschränkungen arbeiten, die Demos ignorieren:

- Zugriffskontrolle: Benutzer dürfen nur das sehen, wozu sie berechtigt sind.

- Datenschutz: PII (persönlich identifizierbare Informationen) und sensible Daten dürfen nicht in Prompts, Logs oder Antworten durchsickern.

- Nachvollziehbarkeit: Sie brauchen Rückverfolgbarkeit – welche Inhalte verwendet wurden, welche Aktion ausgeführt wurde und warum.

- Aktualität: Veraltete Dokumente führen zu falschen Entscheidungen.

- Verantwortlichkeit: Jemand muss für Inhaltsqualität und Updates verantwortlich sein.

- Zuverlässigkeit: Das System muss im Fehlerfall einen reibungslosen Ablauf gewährleisten und bei Bedarf an den Menschen übergeben.

Mit anderen Worten: "Vertrauen" ist wiederholbare Genauigkeit plus Rückverfolgbarkeit zu kontrollierten Quellen.

Welche Daten Sie tatsächlich benötigen

Ein nützlicher Unternehmens-Chatbot ist selten "auf alles trainiert". Er funktioniert am besten, wenn er in kontrollierten Inhalten und operativem Kontext verankert ist. Typische Inputs umfassen:

- Wissensdatenbank-Inhalte: Richtlinien, SOPs, Onboarding-Leitfäden, Produktdokumentation, FAQs.

- Operative Artefakte: Ticket-Kategorien, genehmigte Antwortvorlagen, Lösungsnotizen, Eskalationsregeln.

- Kundenkontext (falls geregelt): CRM-Attribute, Bestellstatus, Plandetails, Historie - nur dort, wo Zugriff und Compliance es erlauben.

Wenn der Bot keinen Zugriff auf die Inhalte hat, die Ihre Mitarbeiter tatsächlich für ihre tägliche Arbeit nutzen, wird er nur generische Ratschläge geben. Das verschiebt den Arbeitsaufwand lediglich, anstatt ihn zu eliminieren.

Viele Unternehmenssysteme verlassen sich auf die Wissensextraktion aus einem Dokumentenbestand, um Antworten abzusichern (Grounding). Einige Implementierungen nutzen dafür Retrieval-Augmented Generation (RAG) – eine Methode, bei der der Bot interne Dokumente durchsucht und die gefundenen Passagen nutzt, um seine Antwort zu belegen. Die Bezeichnung ist dabei weniger wichtig als die technische Anforderung: Antworten müssen zwingend in kontrollierten Quellen verankert sein.

Warum Daten Projekte meistens zu Fall bringen

Chatbot-Projekte scheitern an Daten aus immergleichen, vorhersehbaren Gründen:

- Inhalte sind fragmentiert: Wissen ist über Wikis, Netzlaufwerke, E-Mails und PDFs verstreut.

- Dubletten und Konflikte: Es existieren widersprüchliche Versionen desselben Dokuments.

- Fehlende Aktualität: Die „neueste Version“ ist nicht eindeutig identifizierbar.

- Mangelnde Metadaten: Dokumenten fehlen Informationen zu Produkt, Region, Datum oder Verantwortlichkeit.

- Fehlende Ownership: Niemand ist für die Richtigkeit verantwortlich oder definiert einen Aktualisierungs-Rhythmus.

- Unklare Sicherheitsgrenzen: Zugriffsberechtigungen sind nicht sauber definiert, was den Rollout in späten Phasen blockiert.

Ein Chatbot wirkt wie ein Verstärker für Datenprobleme: Wenn Ihre Wissensbasis chaotisch ist, wird der Bot dieses Chaos mit absoluter Überzeugung widerspiegeln.

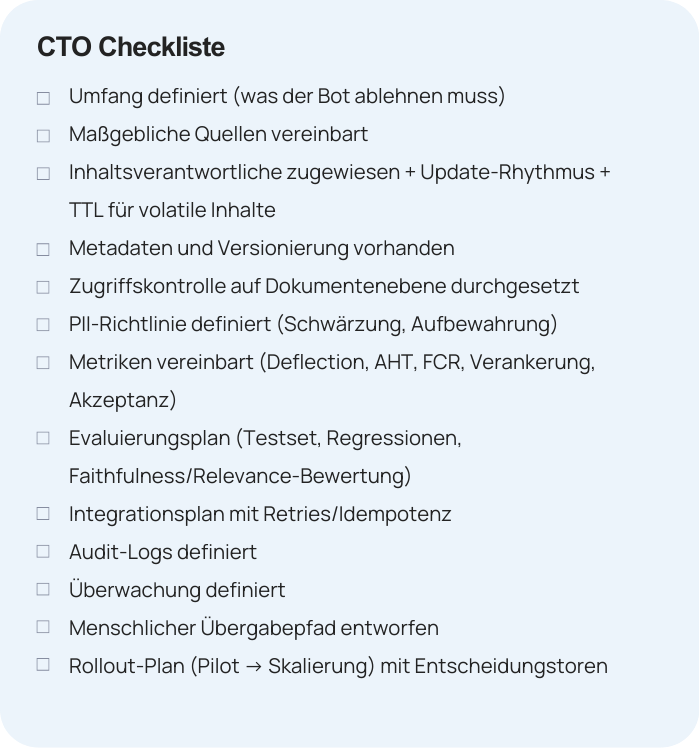

Die Baseline für „Data Readiness“

Eine realistische Grundlage für die KI-Readiness Ihrer Daten umfasst:

- Definierter Scope: Festlegung, welche Bereiche der Bot abdeckt und was er explizit ablehnen muss.

- Quell-Grenzen (Source Boundaries): Bestimmung, welche Repositories als „Authoritative Sources“ (einzige Wahrheitsquelle) gelten.

- Strategie zur Datenspeicherung: Ein zentraler Ort (oder Index), an dem Inhalte konsolidiert und kontrolliert eingespielt werden.

- Metadaten und Versionierung: Zeitstempel, Produkt-Tags, Region/Sprache und Dokumentenstatus.

- Ownership-Modell: Benannte Verantwortliche für Datensätze, festgelegte Review-Zyklen und Regeln für die Archivierung.

- Berechtigungskonzept: Rollenbasierter Zugriff (RBAC) auf Dokumentenebene sowie Schwärzung (Redaction) sensibler Infos, wo nötig.

Um dies nachhaltig zu gestalten, müssen Sie Wissen als lebendes Asset mit einem Lebenszyklus betrachten.

Wissens-Lebenszyklus: Alterung, TTL und Feedback-Loops

- Das Altern von Wissen ist unvermeidlich: Richtlinien, Tools und Organisationsstrukturen ändern sich. Was im letzten Quartal „richtig“ war, ist heute „falsch“.

- TTL (Time-to-Live) für Inhalte: Weisen Sie jedem Dokument eine „Lebensdauer“ basierend auf dessen Volatilität und Risiko zu (z. B. 30/90/180 Tage). Läuft die TTL ab, erhalten die Verantwortlichen automatisch eine Benachrichtigung zur Prüfung. Erfolgt kein Review, wird das Dokument im Such-Ranking herabgestuft oder für den Chatbot als „veraltet“ markiert.

- Feedback-Loop der Nutzer: Jede Antwort des Bots sollte eine Bewertung ermöglichen („Daumen runter / nicht hilfreich“). Ein negatives Signal muss mehr tun, als nur eine Statistik zu füttern:

- Automatisches Erstellen eines Tickets für den Content-Verantwortlichen.

- Übermittlung der Frage, der Antwort, der genutzten Quellen und des Nutzerkommentars.

- Nachverfolgung der Korrektur und Aktualisierung der Historie.

Dies schließt den Kreis von „Nutzer-Problem“ → „Wissens-Korrektur“ und verhindert den schleichenden Qualitätsverlust.

Wenn Sie nicht klar benennen können, wer die Inhalte besitzt und wie sie aktuell gehalten werden, sind Sie noch nicht bereit für den Live-Betrieb.

Warum Piloten stecken bleiben

Die meisten Chatbot-Piloten stagnieren, weil sie das Falsche messen. Teams feiern, dass der Bot Fragen beantworten kann, aber sie definieren keine operativen Erfolgskriterien. Ohne Metriken gibt es keine Grundlage für Priorisierung, Budgetentscheidungen oder Skalierung. Das Projekt wird zu einem ewigen Experiment.

Metriken, auf die es ankommt

Wählen Sie ein präzises Set an Kennzahlen und definieren Sie diese spezifisch für Ihren Kontext:

- Deflection Rate (Automatisierungsquote): Der Anteil der Anfragen, die ohne menschliches Eingreifen gelöst wurden.

- AHT (Average Handle Time): Durchschnittliche Bearbeitungszeit pro Ticket; der Bot sollte diese spürbar senken.

- FCR (First Contact Resolution): Probleme, die bereits in der ersten Interaktion final gelöst werden.

- Time to Resolution: Die End-to-End-Zeit bis zur Lösung, inklusive aller Übergaben (Handoffs).

- Accuracy / Groundedness (Genauigkeit/Fundierung): Der Anteil der Antworten, die durch interne Quellen belegt sind; Ziel ist die Minimierung des Risikos für nicht fundierte Aussagen (Halluzinationen).

- Adoption (Akzeptanz): Anzahl der aktiven Nutzer und die Rate der wiederkehrenden Nutzung.

- CSAT (Customer Satisfaction Score): Optional, aber sehr nützlich, wenn der Chatbot direkt in kundenorientierten Prozessen eingesetzt wird.

Das Metrik-Set sollte zwingend vor Beginn der Implementierung festgelegt werden. Zudem muss ein Verantwortlicher (Owner) benannt werden, der für das regelmäßige Reporting dieser Zahlen zuständig ist.

Überschlags-ROI-Beispiel (Illustrativ)

Angenommen, ein Support-Team erhält 10.000 Tickets/Monat.

Die durchschnittliche Bearbeitungszeit beträgt 12 Minuten.

Die vollständig belasteten Kosten betragen 40 €/Stunde.

Monatlicher Aufwand: 10.000 × 12 Min. = 120.000 Min. = 2.000 Stunden

Kosten-Baseline: 2.000 × 40 € = 80.000 €/Monat

Jetzt nehmen wir an:

- der Bot leitet 15% der Tickets ab (1.500 Tickets),

- und reduziert die Bearbeitungszeit um 20% bei den verbleibenden 8.500 Tickets.

Einsparungen:

- Deflection: 1.500 × 12 Min. = 18.000 Min. = 300 Stunden → 12.000 €

- AHT-Reduktion: 8.500 × (12 Min. × 20%) = 20.400 Min. = 340 Stunden → 13.600 €

Geschätzte Gesamteinsparungen: 25.600 €/Monat

Kosten (illustrativ):

- Laufzeit (4.000 €/Monat): Hosting und Betrieb des LLM-fähigen Stacks (Modell-Hosting oder API-Gateway, Token-Kosten, Compute, Storage, Vektor-Datenbank, Networking), inklusive Basis-Observability und der Kosten für Daten-Updates (Re-Ingestion, Re-Chunking und Re-Indexing).

- Wartung (6.000 € /Monat): Laufender Engineering- und Support-Aufwand (ein technischer Spezialist verantwortlich für Monitoring, Prompt- und Konfigurations-Updates, Evaluations-Läufe, Incident-Management und die Hygiene beim Einspielen neuer Inhalte).

- Integrations-Amortisation (5.000 €/Monat): Die einmaligen Aufbau- und Integrationskosten, verteilt auf ein Jahr (Konnektoren zu Ticketing/CRM, Authentifizierungs-Flows, Audit-Logging, Workflow-Orchestrierung).

Gesamtkosten: 15.000 €/Monat

Nettogewinn monatlich: 25.600 €/Monat - 15.000 €/Monat = 10.600 €/Monat (reiner Gewinn).

Es geht hier nicht um die exakte Zahl auf den Cent genau. Der entscheidende Punkt ist, ein Modell zu haben, das Klarheit über die zugrunde liegenden Annahmen erzwingt und es Ihnen ermöglicht, rationale Entscheidungen zu treffen.

Auswahl des ersten Use Case

Wählen Sie für den Start einen Anwendungsfall mit folgenden Eigenschaften:

- Hohes Volumen an repetitiven Anfragen: Wo fällt die meiste Routinearbeit an?

- Begrenztes Wissensgebiet und eindeutige Antworten: Keine Grauzonen, sondern klare Fakten.

- Geringes regulatorisches und kundenseitiges Risiko: Ein sicheres Umfeld für die ersten Schritte.

- Klarer Fallback zu Menschen: Ein definierter Weg, wie ein Mitarbeiter übernimmt, wenn der Bot nicht weiterweiß.

- Messbare Ergebnisse innerhalb weniger Wochen: Schnelle Validierung statt monatelanger Ungewissheit.

Antworten vs. Handeln

Es gibt eine klare Grenze zwischen Chatbots, die lediglich antworten, und Assistenten, die Probleme lösen.

- Antworten: Richtlinien abrufen, Anweisungen geben, interne Dokumente zusammenfassen.

- Handeln: Tickets erstellen, Bestellstatus prüfen, Buchungen ändern, Rückerstattungen auslösen, Workflows starten, korrekt eskalieren.

Wenn Ihr Ziel eine messbare operative Wirkung ist, zählt das Handeln. Reines „Antworten“ verschiebt die Arbeit oft nur, anstatt sie zu eliminieren.

Typische Integrationsziele

Häufige Ziele für die Systemintegration sind:

- Ticketing- und Case-Management-Systeme.

- CRM (Customer Relationship Management).

- ERP- oder Bestellsysteme.

- Booking Engines (speziell in Reise- und Hospitality-Szenarien).

- IAM/SSO (Identity and Access Management / Single Sign-On).

- Dokumentenmanagementsysteme.

Orchestrierung und Guardrails

Integration erfordert Orchestrierung: Eine Schicht, die Tools aufruft, Richtlinien (Policies) durchsetzt, Fehler behandelt und Aktionen protokolliert. Ein minimales Orchestrierungs-Design umfasst:

- Authentifizierung und Scoped Tokens: Sicherstellen, dass der Bot nur berechtigte Zugriffe ausführt.

- Rate Limits und Retries: Schutz der Zielsysteme vor Überlastung und Umgang mit kurzen Ausfällen.

- Idempotenz bei Aktionen: Sicherstellen, dass eine Aktion (z. B. eine Buchung) bei einer Wiederholung nicht doppelt ausgeführt wird.

- Human Handoff bei Unsicherheit: Nahtlose Übergabe an einen Mitarbeiter, wenn der Prozess stockt.

- Audit Trails für jede Aktion: Lückenlose Dokumentation, wer was wann ausgelöst hat.

- Monitoring und Alerts: Sofortige Benachrichtigung bei Fehlern im Workflow.

Low-Code-Workflow-Tools (z. B. n8n) können einen MVP (Minimum Viable Product) beschleunigen, da sie Integrationen visualisieren und schnelle Iterationen ermöglichen. Die Einschränkung bleibt jedoch die Governance: Bei einer Skalierung benötigen Sie weiterhin Versionierung, Sicherheitskontrollen und eine Observability, die professionellen Engineering-Standards entspricht.

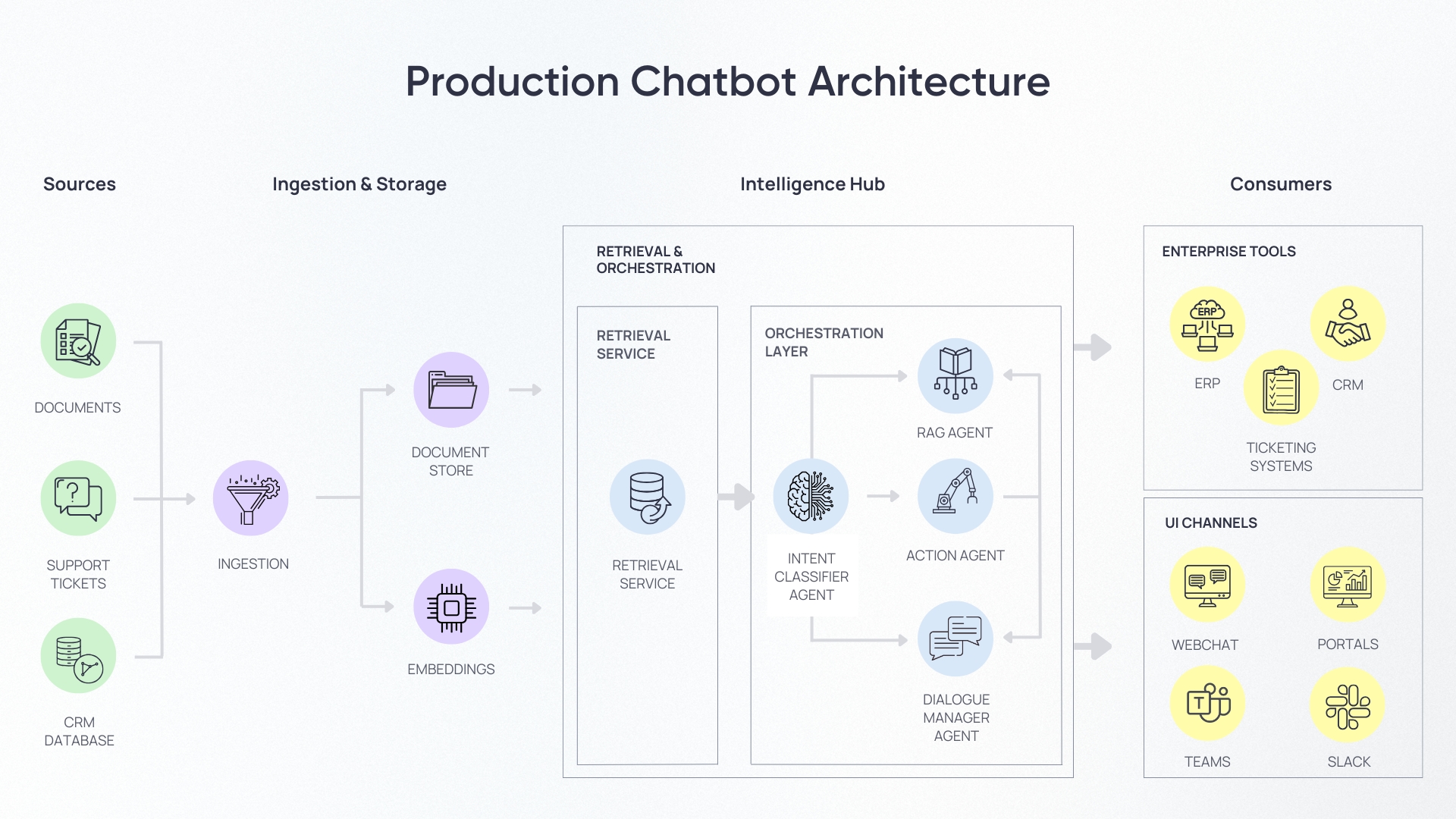

Referenz-Architektur: Eine CTO-freundliche Ansicht

Ein Produktions-Chatbot-System kann als Pipeline visualisiert werden:

Folgende Guardrails sind obligatorisch:

- Authentifizierung und Autorisierung, einschließlich RBAC

- Berechtigungen auf Dokumentenebene

- PII-Handhabung und Schwärzung

- Prompt-Injection-Schutz: Verhindern Sie Manipulationen, bei denen Nutzer den Bot dazu bringen, Systemanweisungen zu ignorieren oder geschützte Daten preiszugeben.

- Data Residency: Entscheiden Sie frühzeitig: Cloud-API oder kontrolliertes Hosting (On-Premise/VPC). Unverzichtbar für Compliance und Datensensibilität.

- Audit-Tiefe: Protokollieren Sie den gesamten Prozess – von Suchanfragen und Dokument-IDs bis hin zu Tool-Aufrufen. Nur so bleibt nachvollziehbar, warum der Bot eine bestimmte Antwort gab.

- Logging und Audit-Trail

- Evaluierungs-/Test-Gates

- Überwachung, Alarme, Incident Response

- Menschlicher Fallback und Eskalation

Evaluation: Woher Sie wissen, dass der Bot “grounded” ist

Bei der Nutzung von Wissensdatenbanken reicht ein „klingt richtig“ nicht aus. Sie brauchen messbare Fakten:

- Faithfulness (Treue): Entspricht die Antwort exakt dem gefundenen Kontext oder erfindet der Bot Fakten dazu?

- Answer Relevance: Löst die Antwort die eigentliche Absicht des Nutzers oder wird nur verwandter Text ausgegeben?

Ein skalierbarer Ansatz ist LLM-as-a-Judge: Ein leistungsstärkeres Modell bewertet automatisch die Antworten des Bots.

- Speichern: Frage, Kontext-Passagen und Antwort sichern.

- Scoring: Das „Richter-Modell“ bewertet Treue und Relevanz.

- Flagging: Antworten unter einem Schwellenwert werden markiert oder blockiert.

- Optimierung: Diese Fälle fließen in Review-Warteschlangen und Regressionstests.

So wird Qualität messbar und Fehler werden erkannt, bevor sie den Nutzer erreichen.

Häufige Fehlermodi und wie man sie vermeidet

Veraltete Inhalte → Verantwortliche definieren, TTL, Update-Rhythmus; abgelaufene Dokumente herabstufen.

Keine Verantwortlichkeit → Rechenschaftspflichtige Verantwortliche pro Domäne zuweisen.

Keine ROI-Metriken → Ziele und Baseline vor dem Bauen definieren.

Keine Integrationen → Mindestens einen "Tun"-Workflow früh priorisieren.

Schwache Zugriffskontrolle → Berechtigungen auf Dokumentenebene von Tag eins durchsetzen.

Keine Evaluierung → Festes Testset plus automatisierte Bewertung pflegen.

Keine Überwachung → Nutzung, Fehler, Latenz, Kosten pro Anfrage instrumentieren.

Real-World-Proof: Vom Antworten zum Handeln (Unser Reise-Case)

Der entscheidende Reifeschritt liegt zwischen einem „netten Chatbot“ und einem operativen Assistenten, der Workflows autonom ausführt. Wir haben diesen Schritt vollzogen: Durch die Kombination aus tiefer Integration, präziser Orchestrierung und kontrolliertem Knowledge Retrieval haben wir bewiesen, dass KI echte Geschäftsprozesse übernehmen kann.

Ein konkretes Beispiel ist der von uns entwickelte KI-Reiseassistent. Er geht weit über einfaches Q&A hinaus: Er versteht komplexe Reise-Anforderungen, sammelt notwendige Parameter und führt Buchungen direkt in den integrierten Systemen aus – Ende-zu-Ende.

Was wir aus diesem Case gelernt haben: Wenn ein Assistent darauf ausgelegt ist zu handeln statt nur zu antworten, ändert sich das Engineering radikal. Workflows werden zum zentralen Element, Integrationsgrenzen müssen exakt definiert sein und operative Leitplanken entscheiden darüber, ob das System in echten Kundeninteraktionen bestehen kann.

Erfahren Sie hier im Detail, wie wir den KI-Travel-Agent gebaut haben.

KI-Readiness-Workshop

Die meisten Chatbot-Initiativen scheitern früh, weil Teams zur Implementierung springen, bevor sie sich über Umfang, Daten, Metriken und Integrationen abstimmen. Ein KI-Readiness-Workshop ist ein praktischer Weg, um eine Chatbot-Idee in einen ausführbaren Plan zu verwandeln.

Das passiert im Workshop:

- Use-Case-Selektion: 1–3 Szenarien mit klarem Business-Impact und definiertem Risikoprofil auswählen.

- Data Readiness Check: Analyse von Quellen, Qualität, Aktualität, Ownership und TTL-Regeln.

- Integrations-Mapping: Identifikation notwendiger Systeme (APIs), technischer Hürden und Fehler-Handling.

- ROI-Hypothese: Definition von Erfolgskennzahlen (Baseline vs. Zielwerte).

- Architektur-Entwurf: Skizzierung der Ziel-Struktur inklusive operativer Leitplanken und Evaluations-Strategie.

- Compliance-Review: Prüfung von Datenschutz (Privacy), Zugriffskontrolle, Audit-Anforderungen und Data Residency.

Deliverables:

- Priorisiertes Backlog (Daten + Integrationen + Produktarbeit)

- Pilot-Plan für 4–8 Wochen mit Entscheidungstoren

- Erfolgsmetriken und Messansatz

- High-Level-Architekturskizze und Leitplanken-Checkliste

- Evaluierungsplan (Testset + automatisierte Bewertungstore)

- Risikoregister mit Mitigationen

Wenn Sie einen KI-Chatbot wollen, der den ersten Kontakt mit der Produktion überlebt, beginnen Sie damit, Daten-, ROI- und Integrationsbereitschaft zu validieren, bevor Sie bauen.